Mengenal Metode Algoritma Decision Tree dan Cara Kerjanya

Dalam dunia kecerdasan buatan (AI) dan data mining, algoritma Decision Tree merupakan salah satu metode yang paling populer dan mudah dipahami. Metode ini digunakan untuk klasifikasi dan prediksi dengan pendekatan yang menyerupai proses pengambilan keputusan manusia secara bertahap. Artikel ini akan mengulas secara lengkap tentang apa itu algoritma Decision Tree dan bagaimana cara kerjanya.

Apa Itu Algoritma Decision Tree?

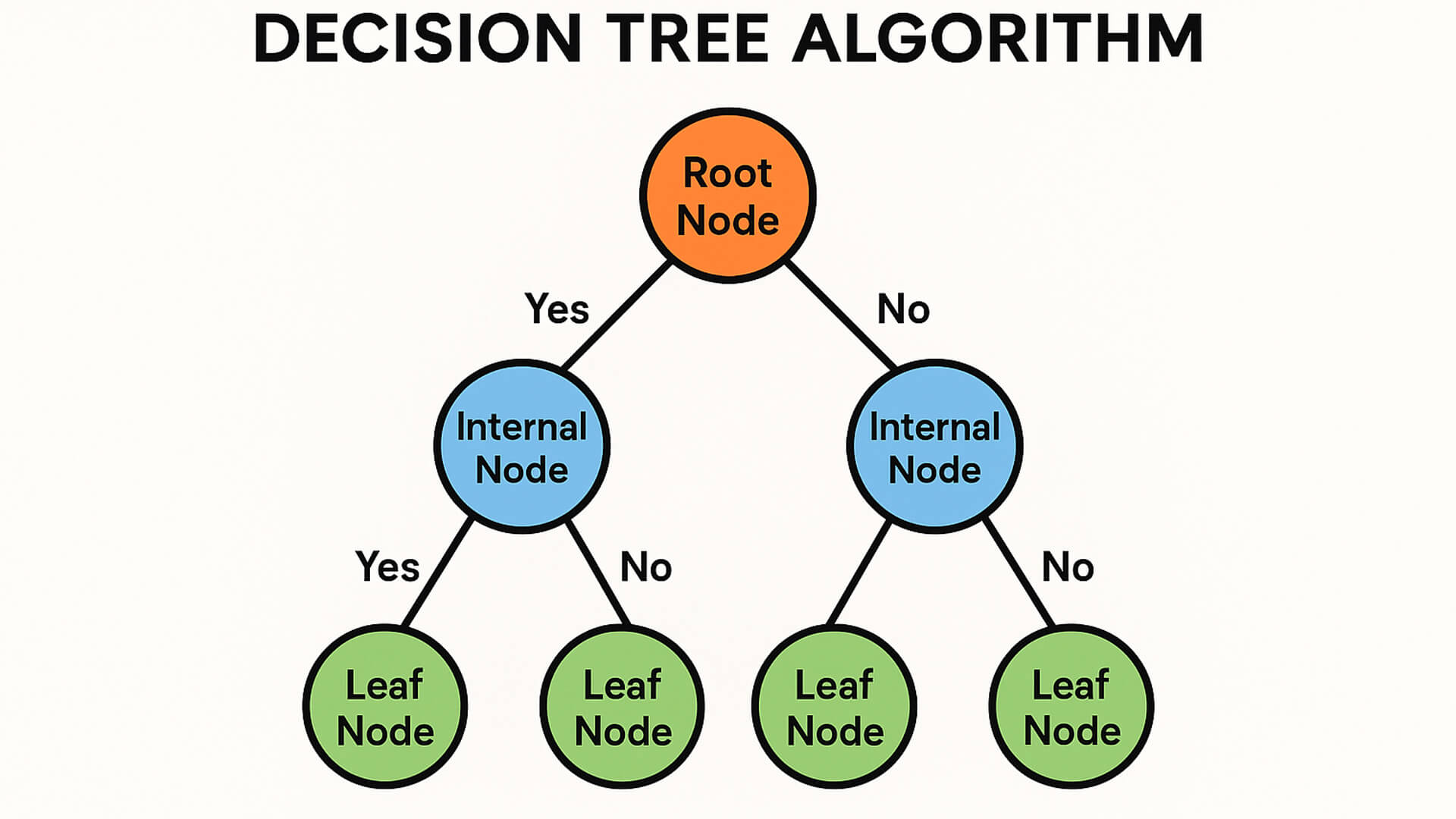

Decision Tree atau pohon keputusan adalah algoritma yang digunakan untuk memecahkan masalah klasifikasi dan regresi dengan membentuk struktur seperti pohon bercabang, di mana setiap node mewakili suatu kondisi atau atribut, dan setiap cabang menunjukkan hasil dari kondisi tersebut hingga mencapai daun (leaf node) sebagai keputusan akhir.

Metode ini bekerja dengan membagi data ke dalam subset berdasarkan atribut yang paling signifikan dalam memisahkan kelas target.

Struktur Decision Tree

Sebuah Decision Tree terdiri dari beberapa elemen utama:

-

Root Node: Node pertama yang mewakili atribut awal dalam pemisahan data.

-

Internal Node: Node yang mewakili atribut yang digunakan untuk membagi data lebih lanjut.

-

Leaf Node: Node akhir yang menunjukkan hasil keputusan atau klasifikasi.

-

Cabang (Branch): Jalur dari satu node ke node lain yang mewakili hasil dari sebuah kondisi.

Cara Kerja Algoritma Decision Tree

Berikut adalah langkah-langkah umum dalam membangun Decision Tree:

-

Pilih atribut terbaik sebagai root

Pemilihan atribut terbaik dilakukan dengan menghitung nilai Information Gain, Gini Index, atau Gain Ratio, tergantung pada metode yang digunakan. -

Bagi dataset berdasarkan nilai atribut tersebut

Data dibagi ke dalam cabang berdasarkan nilai atribut terpilih. -

Lakukan proses rekursif

Untuk setiap subset, ulangi langkah 1 dan 2 hingga:-

Semua data dalam subset termasuk dalam satu kelas yang sama, atau

-

Tidak ada atribut lagi untuk dipilih.

-

Metode Pemilihan Atribut

Beberapa metode umum untuk menentukan atribut terbaik dalam membangun tree:

1. ID3 (Iterative Dichotomiser 3)

Menggunakan Information Gain untuk memilih atribut. Semakin besar Information Gain, semakin baik atribut tersebut.

Rumus Entropy:

Entropy(S) = -∑ pi * log2(pi)

Rumus Information Gain:

Gain(S, A) = Entropy(S) - ∑ (|Si| / |S|) * Entropy(Si)

2. C4.5

Merupakan pengembangan dari ID3, menggunakan Gain Ratio agar lebih adil dalam memilih atribut dengan banyak nilai.

3. CART (Classification and Regression Tree)

Menggunakan Gini Index untuk pemilihan atribut, cocok untuk klasifikasi biner.

Rumus Gini Index:

Gini(S) = 1 - ∑ (pi)^2

Kelebihan Decision Tree

-

Mudah dipahami dan divisualisasikan.

-

Tidak memerlukan prapemrosesan data secara intensif.

-

Mampu menangani data numerik dan kategorikal.

-

Dapat digunakan untuk klasifikasi maupun regresi.

Kekurangan Decision Tree

-

Rentan terhadap overfitting, terutama pada dataset yang kompleks.

-

Hasilnya bisa berubah drastis jika data sedikit berubah.

-

Tidak efisien untuk dataset yang sangat besar tanpa pruning.

Kesimpulan

Algoritma Decision Tree adalah metode yang kuat dan intuitif dalam menyelesaikan permasalahan klasifikasi dan prediksi. Dengan pendekatan berbasis aturan dan pemecahan masalah yang menyerupai logika manusia, algoritma ini banyak digunakan dalam berbagai aplikasi mulai dari diagnosa medis, prediksi kerusakan, hingga analisis perilaku pelanggan.

Memahami cara kerja dan metodenya, seperti ID3, C4.5, dan CART, sangat penting untuk memaksimalkan penggunaannya dalam pengolahan data yang akurat dan efisien.